近日,第39届神经信息处理系统大会(NeurIPS 2025)公布了录用论文,上海电力大学副教授杜海舟团队撰写的论文《FedFree: Breaking Knowledge-sharing Barriers through Layer-wise Alignment in Heterogeneous Federated Learning》成功入选,这也是该团队连续第二年在NeurIPS上发表分布式机器学习领域研究成果。

异构分布式机器学习中,异构模型训练难以聚合收敛是整个过程的核心瓶颈问题。现有方法往往依赖代理数据或模型压缩方法,其容易带来隐私风险与知识传递不完整的问题。

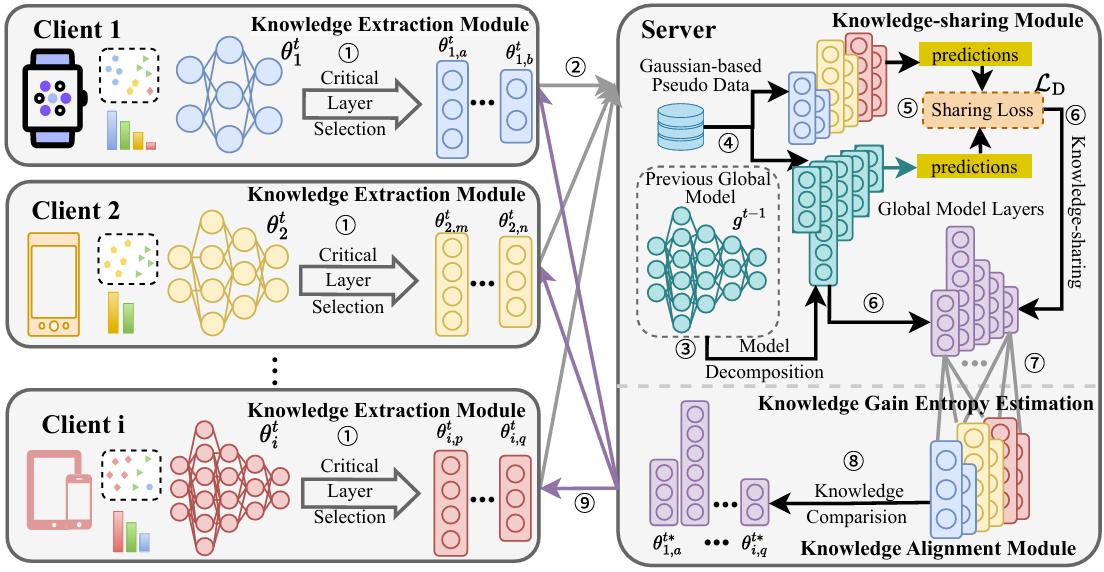

针对此问题,研究团队提出了新框架FedFree,并通过逐层知识对齐机制,实现跨异构模型的数据无关知识共享。具体而言,FedFree 设计了逆向分层知识迁移机制与知识增益熵(Knowledge Gain Entropy, KGE)指标,在保证隐私安全的前提下,有效缓解了细粒度知识丢失问题,实现了跨异构设备的高效知识共享。理论分析与实验结果表明,FedFree 不仅实现了严格的收敛性保证,而且在计算机视觉典型数据集上显著优于现有方法,最高精度提升超过46%。

FedFree框架整体架构概览。图片由研究团队提供

FedFree框架整体架构概览。图片由研究团队提供

?

研究团队表示,该研究成果应用场景广阔,为构建面向大模型时代的高效、安全、普适的分布式智能系统提供了新路径。

在基于无人机群的电力线路巡检等领域,FedFree框架的数据隐私保护特性能够有效提升异构识别模型整体性能;在边缘计算场景中,FedFree框架不仅能够提升异构设备间的协同建模能力,而且打破了异构设备之间的知识共享壁垒,为边缘智能与隐私计算的深度融合提供了一条新方法;同时FedFree框架也为生成式人工智能时代的大小模型协同工作提供了一种新思路。

版权声明:凡本网注明“来源:中国科学报、科学网、科学新闻杂志”的所有作品,网站转载,请在正文上方注明来源和作者,且不得对内容作实质性改动;微信公众号、头条号等新媒体平台,转载请联系授权。邮箱:shouquan@stimes.cn。