近日,清华大学深圳国际研究生院耿子涵团队联合日本理化学研究所、香港城市大学等单位,成功研发出一套融合双目超透镜与光学线索融合网络的高精度三维成像系统。相关研究成果发表于npj Nanophotonics。

该系统创新性地结合了物理推导的绝对立体深度测量与机器学习估算的相对深度信息,通过自适应置信度映射实现高精度、鲁棒的三维重建,有效拓展了三维成像的适用场景和精度边界。

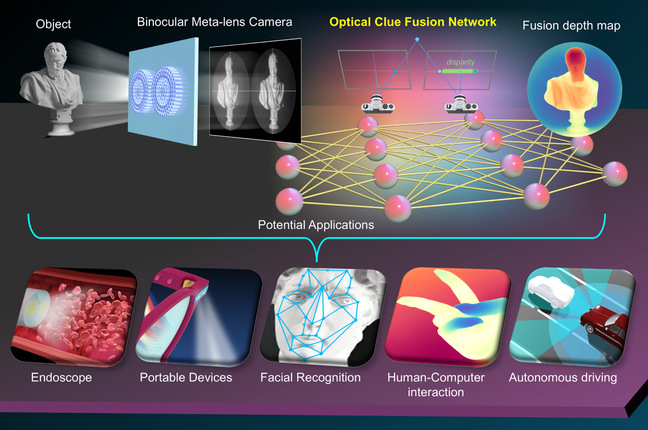

高集成三维成像系统原理及应用示意图。研究团队供图

高集成三维成像系统原理及应用示意图。研究团队供图

?

三维成像技术在自动驾驶、医学诊断及工业检测等领域中具有重要应用价值。传统的三维成像方案普遍存在系统体积大、结构复杂、精度有限等问题,难以满足现代视觉系统对小型化、高性能的迫切需求。近年来,纳米光子学的发展促生了超透镜等新型光学器件,使得三维成像设备更加紧凑。如何突破复杂场景下的深度估算精度瓶颈,成为当前研究热点。

在该项研究中,研究团队提出了一种基于双目超透镜和光学线索融合网络(OCFN)的高精度三维成像系统。该系统通过双目超透镜采集左右视角图像,并利用融合网络将物理立体视差得到的稀疏绝对深度与深度学习模型预测的稠密相对深度进行自适应融合,实现了高精度、高可靠性的三维重建。

该系统核心的双目超透镜由两片直径2.6毫米、间距4毫米的高性能超透镜组成,采用氮化镓纳米柱作为超透镜的基本单元,每个单元提供不同的相位调控。实验结果显示,超透镜的聚焦效率高达74%,焦距偏差小于0.5%,可无缝集成于CMOS图像传感器,实现单次曝光双目成像。

此外,团队该验证了该系统的高精度与高分辨特性。实验数据显示,系统在1200×1200分辨率下,单帧深度预测仅需0.6秒,深度估算误差低于1%。在分辨率测试中,该系统可分辨30微米的平面高度差,远超传统立体成像精度,充分满足精密制造等高端应用需求。在扑克牌遮挡、石膏像并列、白纸倾斜等复杂场景中,OCFN网络均能输出结构完整、细节清晰的三维深度图,实现对物体边界和局部细节的准确捕捉。

研究人员表示,该系统结构紧凑、集成度高、成像精度优异,适用于虚拟现实、智能交互、3D人脸识别、医疗导航、工业检测、自动驾驶等多元场景。未来,研究团队将进一步优化网络结构,实现实时三维感知、低功耗嵌入式部署,推动移动设备、机器人等领域的智能化升级。

相关论文信息:https://doi.org/10.1038/s44310-025-00070-9

版权声明:凡本网注明“来源:中国科学报、科学网、科学新闻杂志”的所有作品,网站转载,请在正文上方注明来源和作者,且不得对内容作实质性改动;微信公众号、头条号等新媒体平台,转载请联系授权。邮箱:shouquan@stimes.cn。