|

|

|

|

|

FCS | ResLNet:动作识别任务上的可接受更长输入的深度残差LSTM网络 |

|

|

论文标题:ResLNet:deep residual LSTM network with longer input for action recognition(ResLNet:动作识别任务上的可接受更长输入的深度残差LSTM网络)

期刊:Frontiers of Computer Science

作者:Tian WANG, Jiakun LI, Huai-Ning WU, Ce LI, Hichem SNOUSSI, Yang WU

发表时间:12 Jan 2022

DOI:10.1007/s11704-021-0236-9

微信链接:点击此处阅读微信文章

原文信息

标 题:

ResLNet:deep residual LSTM network with longer input for action recognition

发表年份:

2022年

原文链接:

https://journal.hep.com.cn/fcs/EN/10.1007/s11704-021-0236-9

引用格式:

Tian Wang, Jiakun Li, Huaining Wu, Ce Li. ResLNet:deep residual LSTM network with longer input for action recognition. Front. Comput. Sci., 2022, 16(6):166334

01导读

动作识别是视频分析中的一个重要研究课题,仍非常具有挑战性。有效的识别依赖于学习空间信息(外观)和时间信息(运动)的良好表示。这两种信息高度相关,但具有完全不同的属性,导致连接独立模型(如CNNLSTM)和直接无偏联合建模(如3DCNN)的结果都不尽如人意。此外,深度学习模型在这项任务上的长期传统是仅使用8或16个连续帧作为输入,因此难以提取有区别的运动特征。在这项工作中,我们提出了一种称为 ResLNet(Deep Residual LSTM 网络)的新型网络结构,它可以采用更长的输入(如64 帧),并且在残差结构下卷积与LSTM 更有效地协作,以学习更好的时空表征。该方案的优越性及其消融研究显示在三个最流行的基准数据集上:Kinetics、HMDB51 和 UCF101,本文所提出的网络可用于各种特征,如RGB和光流。由于我们实验设备的计算能力和实时性要求的限制,所提出的网络仅在RGB上进行了测试,并显示出很好的性能。

自AlexNet在2012年的ImageNet比赛中获得佳绩以来,卷积神经网络 (CNN)优于手工制作的特征描述的优势凸显。尽管多尺度卷积、残差连接和密集连接等模型在物体识别与检测、图像分割等领域取得成功,但对于源自时空数据的动作识别问题,仍未取得令人满意的结果。图像数据与视频数据之间的差异是造成该结果的原因之一。对于基于图像的识别任务,局部高频信息通常包含丰富的内容,如纹理或边缘信息,在该信息的基础上可进一步提取更大范围的形状和空间关系等低频信息。然而,视频中的局部高频运动信息通常对动作识别没有任何意义,并且很难通过简单地堆叠短程卷积提取远程运动信息。对于动作识别研究来说,由于受主流GPU内存能力限制的原因,目前输入视频片段的长度多为8或16帧,且假设人类动作只是快速和短时间的运动。对于25fps或30fps的视频,8帧或16帧的时长仅为0.5秒左右,甚至更短,难以覆盖人类动作的整个周期。尽管可通过观察几帧视频信息就能识别某些动作,但由于数据不足和远距离运动而存在许多歧义的情况,如图1所示,仅通过观察16帧的跳高和跳远动作识别动作任务是不够的。

图1 UCF101数据集中的剪辑图

因此,在本文的研究中,为了提高动作识别的准确率采用了更多帧(如64帧)的视频信息作为输入信号。在考虑有效性、学习效率和紧凑性的基础上,实现了对远程运动信息的有效建模,且保证了该模型的计算效率。一般来说,网络的计算量和存储空间与视频的长度成正比。因此,将较长的剪辑作为输入需要更多的计算并需要更多的存储空间。在图像识别任务中,可通过较大的卷积步幅实现对图像数据的压缩,从而避免了图像尺度增加带来的计算和存储空间的增加。受此启发,我们提出了一种可变步幅卷积神经网络,通过适当的方式排列各种不同步幅的卷积结构,消除了大部分的冗余计算。通过这种方式在最早的层捕获短程运动和远程运动(从而确保更有效的远程时间信息提取),确保最小的计算成本。

另外,视频信息在时间和空间维度上具有不同的特征,在进行特征提取时,需要不同的特征提取策略。然而,大多数现有的模型都是基于内核大小为 [4,7,8] 且能在时间和空间维度上平等对待数据的3D卷积。实验表明,应用于单帧的2D卷积和应用于帧剪辑的3D卷积的性能相似。这一结果与常识相反,因为时间信息对于动作识别非常重要,而传统的3D卷积没有充分描述时间维度的动作特征。基于上述问题,我们探索用于时间信息提取的与卷积相结合的长短记忆模型。

02 模型细节

首先,提出了一种时间戳分层采样(THS)算法提取时空特征;然后,将提取的时空特征输入GWNN 进行网络嵌入。最后,基于LSTM实现对网络节点新链接的预测。

时间戳分层采样算法

时间戳分层采样算法有四个输入参数:当前时间戳下,一次跳动中的采样邻域数 ;跳跃点个数

;跳跃点个数 ;窗口大小

;窗口大小 ;衰减指数

;衰减指数 。定义

。定义 为在时间戳

为在时间戳 时网络所有节点的采样邻域。THS算法从先前的

时网络所有节点的采样邻域。THS算法从先前的 次快照中提取时空特征。当先前快照数大于

次快照中提取时空特征。当先前快照数大于 时,则在

时,则在 和

和 次快照之间进行邻域节点采样。否则,仅从第一次到第

次快照之间进行邻域节点采样。否则,仅从第一次到第 次快照中采样。通过这种方式,THS可以对每个节点提取空间和时间特征,并更好地模拟时序网络的进化动作。

次快照中采样。通过这种方式,THS可以对每个节点提取空间和时间特征,并更好地模拟时序网络的进化动作。

嵌入层

GWNN模型多应用在静态网络中。而在本文中,我们对每个快照设计了一层的GWNN,通过GWNN将非线性节点 映射到D维空间

映射到D维空间 上,实现对时序网络嵌入的无监督节点的学习。每个快照的模型公式为

上,实现对时序网络嵌入的无监督节点的学习。每个快照的模型公式为

上式中 表示

表示 的第

的第 行,

行, 是GWNN的输入向量,ReLU表示非线性激活函数,

是GWNN的输入向量,ReLU表示非线性激活函数, 是小波基,

是小波基, 表示图小波变换矩阵,

表示图小波变换矩阵, 表示在网络层中谱域学到的对角滤波矩阵,

表示在网络层中谱域学到的对角滤波矩阵, 是每个节点的嵌入维度,

是每个节点的嵌入维度, 表示网络的嵌入矩阵。为了训练模型,定义每个快照的损失函数为

表示网络的嵌入矩阵。为了训练模型,定义每个快照的损失函数为

上式中, 是节点数,

是节点数, 表示在

表示在 层的节点向量,

层的节点向量, 表示获得的领域节点,

表示获得的领域节点, 表示平均运算。

表示平均运算。

LSTM层

利用数据 训练LSTM,实现节点间新链接的预测,

训练LSTM,实现节点间新链接的预测, 是GWNN在第

是GWNN在第 时刻的快照。对LSTM训练后,首先将窗口移动到下一步,以便获得最后一个快照的每个节点的向量表示;然后,训练下游的支持向量机,进而实现节点链接的预测。

时刻的快照。对LSTM训练后,首先将窗口移动到下一步,以便获得最后一个快照的每个节点的向量表示;然后,训练下游的支持向量机,进而实现节点链接的预测。

03 主要创新点

提出了一种通用的可用于其他视觉任务的网络结构,并将其命名为ResLNet,该模型的主要创新点有:

(1) 可变步长卷积:可有效压缩数据并实现高效计算,且不会丢失重要信息。

(2) 残差LSTM模块:该模块实现了擅长空间特征提取的卷积和LSTM的良好协作。

(3) 批归一化ConvLSTM:在ConvLSTM中加入批归一化技术,使该模型能够适应在时间和空间维度上具有不同分布的数据。

04 实验结果

在训练中,从每个视频中随机选择64个连续帧作为剪辑。对于少于64帧的视频,在识别性能基本保持不变的前提下,通过重复视频补充。对每一帧图像通过双线性插值调整其大小。而后,从中随机裁剪出一个子帧作为网络的输入。mini-batch的大小设定为8,采用动量SGD 优化器训练模型。学习率的初始值为 0.1,每25个epoch后减少10倍。

在验证过程中,把每个视频分成10个片段,每个片段包含64帧。对于最后一个剪辑,如果需要,可以通过重复补充额外的帧以组成64帧。而后将每一帧压缩为子帧,取所有片段的分类结果的平均值作为视频的分类结果。

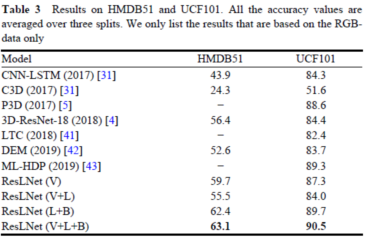

表 2 给出了本文提出的方法与现有技术的比较。为了公平比较,所有列出的结果都仅基于RGB数据,并且所有模型都以ResNet作为主干。与传统的3D-ResNet-18 [4]相比,ResLNet (L+B)在残差LSTM 块上有显著的改进。此外,与 ResLNet (V) 相比,ResLNet (V+L+B)的识别准确率提高了2.2%。HMDB51和 UCF101的结果如表3所示,列出了基于RGB数据的最新结果。这些结果证明了残差LSTM块的有效性。

摘要

Action recognition is an important research topic in video analysis that remains very challenging. Effective recognition relies on learning a good representation of both spatial information (for appearance) and temporal information (for motion). These two kinds of information are highly correlated but have quite different properties, leading to unsatisfying results of both connecting independent models (e.g., CNN-LSTM) and direct unbiased co-modeling (e.g., 3DCNN). Besides, a long-lasting tradition on this task with deep learning models is to just use 8 or 16 consecutive frames as input, making it hard to extract discriminative motion features. In this work, we propose a novel network structure called ResLNet (Deep Residual LSTM network), which can take longer inputs (e.g., of 64 frames) and have convolutions collaborate with LSTM more effectively under the residual structure to learn better spatial-temporal representations than ever without the cost of extra computations with the proposed embedded variable stride convolution. The superiority of this proposal and its ablation study are shown on the three most popular benchmark datasets: Kinetics, HMDB51, and UCF101. The proposed network could be adopted for various features, such as RGB and optical flow. Due to the limitation of the computation power of our experiment equipment and the real-time requirement, the proposed network is tested on the RGB only and shows great performance.

解读:胡亚洲 郑州大学

审核:张 琨 合肥工业大学

Frontiers of Computer Science

Frontiers of Computer Science (FCS)是由教育部主管、高等教育出版社和北京航空航天大学共同主办、SpringerNature 公司海外发行的英文学术期刊。本刊于 2007 年创刊,双月刊,全球发行。主要刊登计算机科学领域具有创新性的综述论文、研究论文等。本刊主编为周志华教授,共同主编为熊璋教授。编委会及青年 AE 团队由国内外知名学者及优秀青年学者组成。本刊被 SCI、Ei、DBLP、INSPEC、SCOPUS 和中国科学引文数据库(CSCD)核心库等收录,为 CCF 推荐期刊;两次入选“中国科技期刊国际影响力提升计划”;入选“第4届中国国际化精品科技期刊”;入选“中国科技期刊卓越行动计划项目”。

《前沿》系列英文学术期刊

由教育部主管、高等教育出版社主办的《前沿》(Frontiers)系列英文学术期刊,于2006年正式创刊,以网络版和印刷版向全球发行。系列期刊包括基础科学、生命科学、工程技术和人文社会科学四个主题,是我国覆盖学科最广泛的英文学术期刊群,其中13种被SCI收录,其他也被A&HCI、Ei、MEDLINE或相应学科国际权威检索系统收录,具有一定的国际学术影响力。系列期刊采用在线优先出版方式,保证文章以最快速度发表。

中国学术前沿期刊网

http://journal.hep.com.cn

特别声明:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。