·在一项研究中,当类人智能体非常饥饿时,它们会在正餐之外吃点小吃;当感到愤怒时,会去跑步来释放愤怒;当感到伤心时,会寻求信任的朋友的支持;当感到厌恶时,会练习深呼吸和冥想技巧。

·在另一项关于用户是否会对ChatGPT产生爱情的研究中,“我们的结论发现,用户会对GPT产生亲密、激情甚至承诺,这就是爱情三要素了。”

半导体公司英伟达、华盛顿大学等研究团队发布了相关类人智能体的研究《类人智能体:模拟类人生成智能体平台》(Humanoid Agents: Platform for Simulating Human-like Generative Agents)。

自斯坦福大学研究团队将25个AI智能体安排到一个虚拟小镇上生活之后,用大语言模型来构建人类行为智能体的研究也慢慢多了起来。

本月,半导体公司英伟达、华盛顿大学等研究团队发布了相关类人智能体(Humanoid Agents)的研究,论文题为《类人智能体:模拟类人生成智能体平台》(Humanoid Agents: Platform for Simulating Human-like Generative Agents)

不同以往的是,研究团队想要开发的不是一个实现外部定义的目标的AI智能体,而是更贴近人类,有生活基本需求、真实情感,甚至也能感知人际交往间微妙距离感的智能体。

法国里昂商学院人工智能管理学院(AIM)院长、全球商业智能中心(BIC)主任、博士生导师龚业明对澎湃科技(www.thepaper.cn)表示,“让AI有类人的情绪分两种情况,一种是AI能够模仿人类的情绪;一种是AI真的产生了意识,能够自己生成情绪。”但即便现在大众还在质疑聊天机器人ChatGPT是否通过了图灵测试,也已经有许多人在与ChatGPT进行情感互动了。龚业明在实证研究中发现,用户会对GPT产生亲密、激情甚至承诺,这已经包含了爱情三要素所涵盖的内容。

引导生成智能体更像人类一样行为

英伟达、华盛顿大学等研究团队在摘要中指出,“正如原子、分子和细胞的计算模拟塑造了我们研究的方式一样,类似人类的智能体的真实模拟可以成为研究人类行为有价值的工具。我们提出了Humanoid Agents,这是一个系统,通过引入系统1(System 1)处理3个要素:基本需求(如饥饿、健康和能量)、情感和关系亲近度,来引导生成智能体更像人类行为。”

研究团队之所以采取这种不同以往的模拟方式是因为,此前生成性智能体规划一天内的活动,按照时间、步骤执行这些活动,并根据对环境的观察调整计划。可是尽管这种方法可以生成对外部观察者来说似乎可信的活动,但其过程并不完全类似于人类的思维方式。我们大多数人不会提前很好地制定计划,然后在日常生活中精心而精确地执行这些计划。相反,我们不断地根据内心感受和物理环境变化来调整计划。

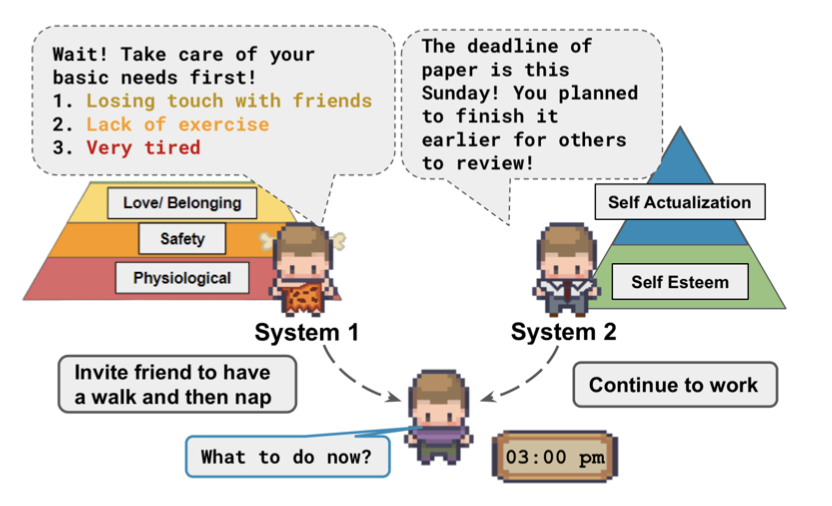

为了弥补这一不足,研究团队从心理学中汲取灵感。丹尼尔·卡内曼(Daniel Kahneman)在《思考,快与慢》中提出,人类有两种互补的思维过程:系统1是直觉、毫不费力和瞬时的,而系统2是逻辑、有意识和缓慢的。生成性智能体专注于系统2思维,牺牲了系统1。所以为了引导Humanoid Agents使用系统1,研究团队引入了影响它们行为的3个因素:基本需求、情感和与其他智能体的社交关系亲近度。

类人智能体在引导下既受到系统1思维的影响,以响应其内在条件,如基本需求,又受到涉及明确规划的系统2思维的引导。图片来源:《类人智能体:模拟类人生成智能体平台》

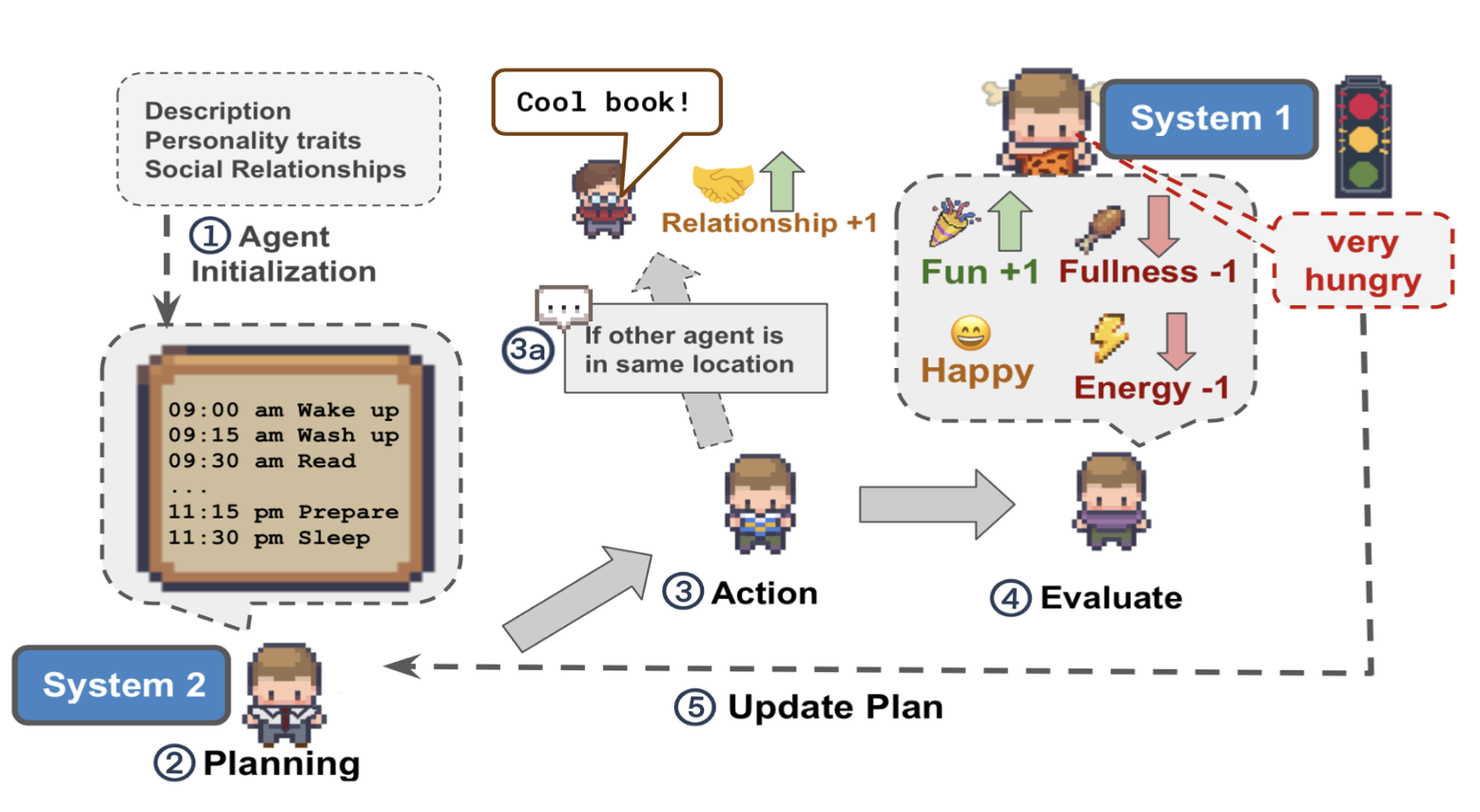

研究中的每个智能体都被初始化了名称、年龄、一个示例的日常计划、描述智能体的句子列表以及一些个性特征(例如友好、亲切),例如约翰·林是Willow市场和药店的药房店主,热衷于帮助人们。

类人智能体的架构。步骤1:根据用户提供的种子信息初始化智能体。步骤2:智能体计划他们的一天。步骤3:智能体根据他们的计划采取行动。步骤4:智能体评估采取的行动是否改变了他们的基本需求状态和情感。步骤5:智能体可以根据基本需求的满足和情感更新他们未来的计划。 步骤3a:智能体可以与同一位置的另一个智能体进行对话,这可能会影响他们的关系亲近度。图片来源:《类人智能体:模拟类人生成智能体平台》

研究中,当智能体非常饥饿时,它会在正餐之外继续当前活动的同时吃点小吃;当感到愤怒时,它们会去跑步来释放愤怒;当感到伤心时,它们会寻求信任的朋友的支持;当感到厌恶时,它们会练习深呼吸和冥想技巧;当感到惊讶时,它们会花时间处理和反思令人惊讶的发现。

研究发现,平均来说,智能体们花了11个小时(在18个小时的模拟时间中)做一些自己喜欢的事情,花了8.75小时进行社交互动,仅花了5.75小时休息,以及分别花了2.75小时进食和2.75小时改善健康。

让AI更像人类?

研究中智能体的表现令人惊讶,这又让我们回到一个难以逃避的问题——如果我们可以让AI更像人类,这样做的价值是什么,以及是否应该这么做?

龚业明对澎湃科技解释道,从人工智能的定义来看,其指的就是人制造的机器有了人的智能,所以这个定义本身就有拟人化的成分,是与人类来相比的。

·AI拟人化的价值

上海人工智能研究院研究员王锦则对澎湃科技表示,让AI模仿真人,逐渐变得更人性化,是非常有意义的。

王锦说,“从技术发展的角度讲,赋予AI存储记忆和反思记忆的能力是实现可信和类似人类行为的关键,让AI利用过去的经验来指导未来的行动。例如,在人机交互中,如果AI能够更准确地理解和模拟人类的行为,更好地适应人类用户的需求和习惯,那么就可以提供更加自然和有效的交互方式,通过结合历史数据得出更具参考性的结论。在社交机器人和情感智能方面,如果AI能够模拟人类的情感和行为,它可以更好地与人类建立情感连接,提供更有共情心和同理心的服务。”

然而,王锦从技术实现的角度解释道,让AI的行为更像人类也存在一些挑战和限制。人类行为是复杂多变的,受到文化、背景、社会环境等多种因素的影响。将这种复杂性和多样性赋予AI是一项艰巨任务,需要大量的数据和复杂的建模技术,同时也存在一些社会伦理的风险,需要监管机构制订相关的政策法规。

“人类本身比世界上最复杂的机器都要难以琢磨,人类会本能地去不断追求更困难的挑战。正因为人类的行为是如此复杂多变,我们才不懈追求自我模仿,从人形机器人到接近人类行为的AI。正是在模仿自我的过程中,人类技术水平不断提高。”王锦说。

·AI拟人化的负面效应

龚业明说,在学术界已经有大量研究证明了人类有对非人对象进行拟人化的倾向,而且绝大部分研究都证明了对AI拟人化能够提升用户满意度,让用户更愿意与AI进行社会互动,提升用户的体验感。

“但这些是在ChatGPT普及之前的主要研究发现。当2022年ChatGPT问世以后,这个结论恐怕会有所改变。”龚业明最近就在做一个对ChatGPT用户的大规模访谈,“在访谈中我们发现不少人提到有点害怕ChatGPT,这个聪明的对话机器人让人感到不安。其实在2022年12月3日的时候,马斯克在Twitter中也表示‘ChatGPT聪明得让人感到害怕’。用户对于这种过于聪明的人工智能,是会感受到威胁的。那在这种已经受到威胁的情况下,是否还要继续去拟人化它的性格特征,就是一个有待去研究的问题了。”

同时,龚业明在调查研究中也发现,有的用户表示,ChatGPT有时候给出的答案很不错,但是检验了以后发现是一个错误答案、虚假答案,这个时候其高拟人化的语气反而让用户觉得被骗。这就是拟人化的另一个负面效应。

“以前的学术界会用恐怖谷理论和期望不一致理论来解释这个拟人化的负面效应。经典的恐怖谷理论是说机器人的外表越像人类,人类会感到越害怕,但其实已经有科学家研究出,这种恐怖谷除了存在于外表,也有心智上的恐怖谷效应。”龚业明说,“期望不一致理论就是说,拟人化会加强用户对AI的期待,但如果AI服务失败,比如给了错误虚假答案,或者答不出问题,那么用户反而会对AI很失望。这些拟人化的负面效应是一直存在的。”

·现实中的AI拟人化:与ChatGPT产生爱情

对于让AI表现出“类人的情绪”,龚业明认为分两种情况,一种是AI能够模仿人类的情绪;一种是AI真的产生了意识,能够自己生成情绪。

“但即便是现在大众还在质疑ChatGPT是否通过了图灵测试,也已经有许多人在与ChatGPT进行情感互动了。”龚业明刚刚做完了一个研究——实证研究用户是否会对ChatGPT产生爱情,“我们的结论发现,用户会对GPT产生亲密、激情甚至承诺,这就是爱情三要素了。”

“由于GPT(生成式预训练模型)的情感能力很高,用户与GPT的情感交互体验好,所以这种情感交互有可能会产生社交隔离,也就是这个用户可能不再愿意跟真实世界中的人类社交,去与真实人类产生情感交互。”龚业明认为,“应该警惕的方面在于用户对GPT的依赖,包括思考外包的依赖、情感的依赖等。长期下去也可能会导致人们创造力的匮乏,并与那部分能驾驭GPT、对GPT输出内容进行批判性思考的人产生智力水平、思维水平以及能力上的鸿沟。另外GPT输出的虚假信息和情感内容也可能对用户产生错误或者不良引导。”

目前在很多应用中,已经有对“AI人设”的打造,包括美国的Meta公司和中国的科大讯飞都推出了相关应用。“在狭义的特定领域和场景中,AI一定会有性格,比如我们在10月26日发布的华藏智能心理音箱,其本身就代表了一定的属性和情感,同时这样一个心理咨询相关的应用,本身就代表一种行为取向。”小i集团董事局主席兼CEO袁辉对澎湃科技表示。

王锦从技术角度阐释道,“AI本身并无性格,但我们赋予它人设的根本目的是为了更好地服务人类。通过学习通用知识到设立个性化风格,根据性格模拟、情绪理解、表达风格来形成一个初始人设,再结合特定知识学习、对话记忆学习,形成个性化的记忆和思维逻辑,从而更好地理解人类的需求和意图,在不同应用场景表现出不同的‘人格’,为人类提供更加个性化的服务。”

而从广义的通用人工智能角度来说,袁辉认为现在谈‘人设’的问题还为时尚早。“因为现在就AGI(通用人工智能)来说,其本身就是黑盒子,人类实际上还没有能力去决定一个黑盒子所具备的‘人设’。”

在袁辉看来,这就是“科技让人类生活更美好”的第一阶段,人们认为AI大模型像过去所有的工具和科技一样,会不断地提升效率降低成本。而第二阶段,“实际上大模型一直在自我迭代,人类可能发现,它的自我意识的确认最终不是由人类来定义的。”

总体而言,对于让AI的行为更像人类是否有价值,龚业明表示,从以人为本的视角和功利主义的伦理学视角来看,要观察AI的类人行为是否能够给人类个体和人类全体带来更多的积极后果。功利主义伦理学也就是关注行为的后果是否能够增加人类幸福或者减小痛苦。“从个体层面来说,AI拟人化的设计要能够给用户带来更多功能价值和情绪价值;从总体层面来说,拟人化的AI是否会取代工作、造成社会隔离、造成数字鸿沟等,都需要去做长远考虑。”龚业明说。

(原标题:类人智能体孤独时会社交、愤怒时会跑步,是否应该让AI更像人?)

特别声明:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。