如何精准识别AI生成内容,是目前亟待解决的热点问题。近日,南开大学计算机学院媒体计算实验室获得最新研究成果,不仅从评估的角度揭示了现有AI检测方法的性能不足,并创新性地提出了“直接差异学习”(DDL)优化策略,教会AI用“火眼金睛”辨别人机不同,实现AI检测性能的巨大突破。

据介绍,目前AI生成内容检测主要有两种路线,一是“基于训练的检测方法”,使用特定数据训练一个专用的分类模型;二是“零样本检测方法”,直接使用一个预训练的语言模型并设计某种分类标准进行分类。

多项研究表明,现有检测方法在应对复杂的现实场景时常显不足。此前也曾有权威媒体报道,《荷塘月色》《流浪地球》等经典作品被某常用论文AI率检测系统检出高AI率。

为何现有的AI检测工具会“误判”?论文第一作者、南开大学计算机学院计算机科学卓越班本科生付嘉晨解释道:“如果把AI文本检测比作一场考试,检测器的训练数据等同于日常练习题,现有检测方法是机械刷题、死记硬背答题的固定套路,难以学会答题逻辑,一旦遇到全新难题,准确率就会显著下降。”

“要想实现通用检测,理论上需收集所有大模型的数据进行训练,但在大模型迭代飞速的今天几乎不可能。”付嘉晨说,让检测器真正学会举一反三,即提升检测器的泛化性能,是提升AI文本检测性能的关键。

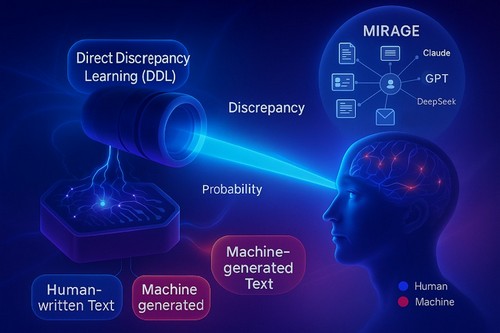

为此,研究团队提出了DDL方法另辟蹊径,通过直接优化模型预测的文本条件概率差异与人为设定的目标值之间的差距,帮助模型学习AI文本检测的内在知识,可以精准捕捉人机文本间的深层语义差异,从而大幅提升检测器的泛化能力与鲁棒性。

“使用DDL训练得到的检测器如同有了‘火眼金睛’,即便只‘学习’过DeepSeek-R1的文本,也能精准识别像GPT-5这样最新大模型生成的内容。”付嘉晨说。

团队还提出了一个全面的测试基准数据集MIRAGE,使用13种主流的商用大模型以及4种先进的开源大模型,从AI生成、润色、重写三个角度构造了接近十万条人类-AI文本对。

图为AI生成内容检测示意图 南开大学供图

图为AI生成内容检测示意图 南开大学供图

?

“MIRAGE是目前唯一聚焦于对商用大语言模型检测的基准数据集。直观地说,之前的基准数据集是由少而且能力简单的大模型命题出卷,而MIRAGE是17个能力强大的大模型联合命题,形成一套高难度、又有代表性的检测试卷。”论文通讯作者、南开大学计算机学院副教授郭春乐说。

在MIRAGE的测试结果显示,现有检测器的准确率从在简单数据集上的90%骤降至约60%;而使用DDL训练的检测器仍保持85%以上的准确率。与斯坦福大学提出的DetectGPT相比,性能相对提升71.62%;与马里兰大学、卡内基梅隆大学等共同提出的Binoculars方法相比,性能相对提升68.03%。

版权声明:凡本网注明“来源:中国科学报、科学网、科学新闻杂志”的所有作品,网站转载,请在正文上方注明来源和作者,且不得对内容作实质性改动;微信公众号、头条号等新媒体平台,转载请联系授权。邮箱:shouquan@stimes.cn。