|

|

|

|

|

QB 全面评估大语言模型在挖掘基因调控网络和通路方面的应用 |

|

|

论文标题:A comprehensive evaluation of large language models in mining gene relations and pathway knowledge

期刊:Quantitative Biology

作者:Muhammad Azam, Yibo Chen, Micheal Olaolu Arowolo, Haowang Liu, Mihail Popescu, Dong Xu

发表时间:21 June 2024

DOI:https://doi.org/10.1002/qub2.57

微信链接:点击此处阅读微信文章

理解复杂的生物学通路,例如基因-基因相互作用和基因调控网络,对于探索疾病机制和药物开发至关重要。然而,通过人工手动整理生物学通路的速度是远远无法跟上这些研究指数级增长的趋势。基于文本语料库上训练的大规模语言模型(LLMs)同样可以用于生物学信息的提取,搭建生物学知识图谱。

最近,美国密苏里大学许东教授课题组在Quantitative Biology期刊上发表了一篇题为“A comprehensive evaluation of large language models in mining gene relations and pathway knowledge” 的研究性论文。文章评估了21种LLMs(包括基于API的模型和开源的模型)在检索生物学知识方面的能力。评估的重点是预测基因调控关系(激活、抑制和磷酸化)以及识别KEGG通路中的基因。结果表明,不同模型之间的性能存在显著差异,总体来说基于API的模型表现优于开源模型,尤其是GPT-4和Claude-Pro在预测基因调控关系方面表现突出。本文的研究表明,LLMs在基因网络和通路分析中是含有大量信息的,但它们的有效性各不相同,需要谨慎选择。本文相关代码可在https://github.com/Muh-aza/LLM查询。

全文概要

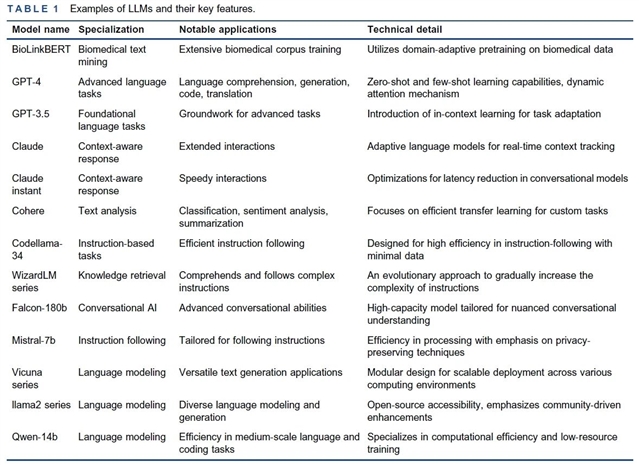

自然语言处理研究领域的一个重要突破是大规模语言模型(Large-scale Language Model, LLM)的出现。LLM的特点是参数量巨大并且需要大量文本语料库的训练,由此可以生成连贯的并与上下文相关的文本。因此,LLM比较适合生物医学文本的生成和挖掘。目前,已有多种LLMs被应用于生物医学研究中。它们的区别,特点,应用场景及技术细节如表1所示。

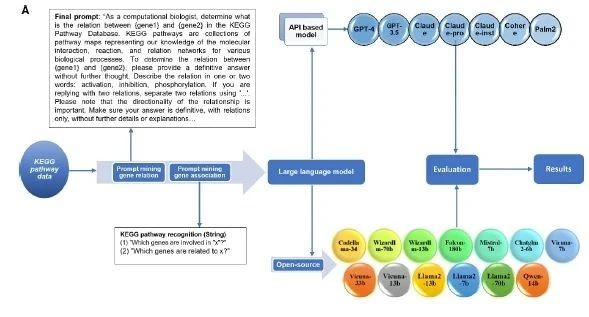

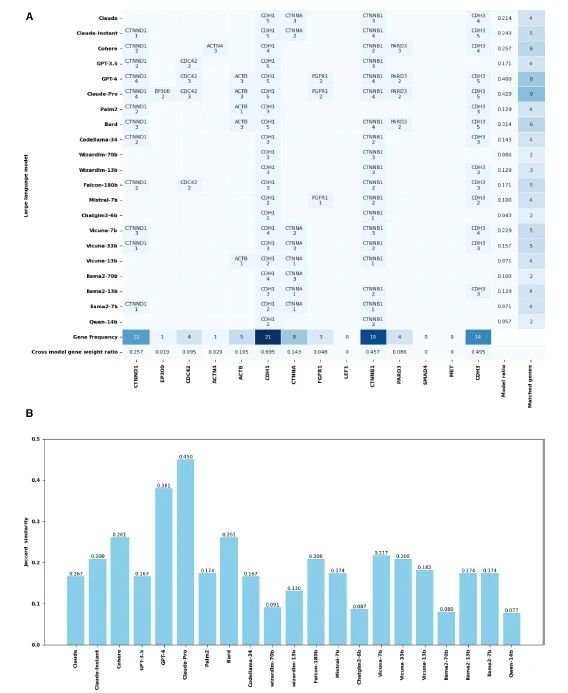

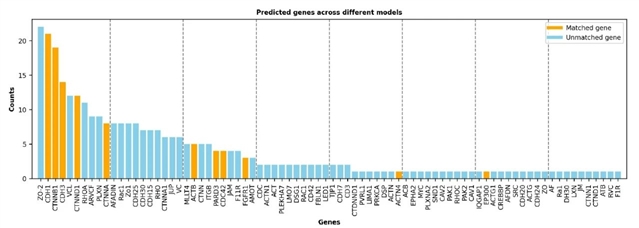

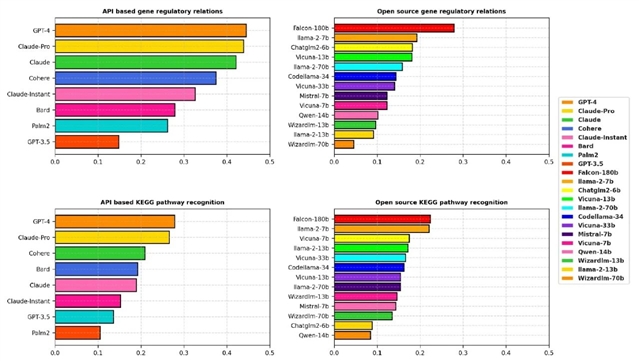

虽然LLMs通常被用作知识库或知识图谱来检索信息,但它们的准确性很少被研究,这可能会阻碍了LLMs的应用和改进。为了解决该问题,本文作者系统地评估了21种LLMs在提取关键生物医学信息方面的能力(如图1),如通路、基因相互作用和调控关系,并且全面评估了基于API的模型和开源模型在预测基因调控关系和KEGG途径中关键基因方面的能力。

图1. 本文所采用的生物医学数据分析中LLM的评估工作流程

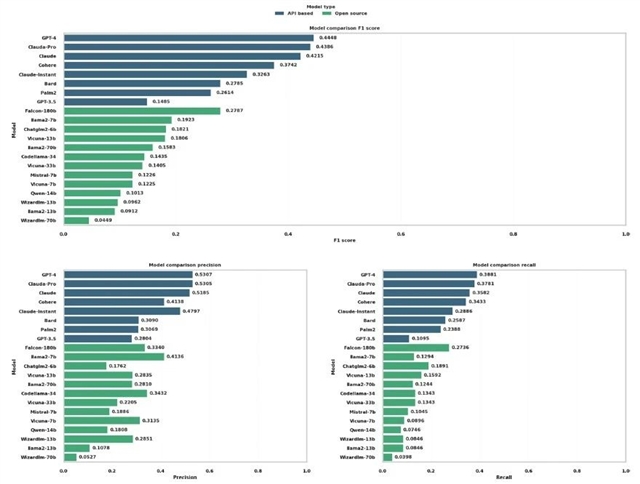

结果表明,基于API的模型表现优于开源模型(图2-5)。

图2. 基于API和开源模型的基因预测准确性的比较分析

图3. 粘附分子连接的基因预测

图4. 使用所有21个LLMs进行粘附连接基因预测的集成学习分析

图5. 21种LLMs在基因调控关系和KEGG通路基因识别方面的性能比较

最后,作者认为LLMs在生物医学知识挖掘中有巨大潜力,将LLMs整合到生物医学研究生态系统中可有望改变复杂生物数据的分析和解释方式,从而加速生物学和医疗健康领域的科学发现和创新。但这需要LLM算法的不断进化和完善,确保其在快速发展的生物医学研究领域的相关性和有效性。

QB期刊介绍

Quantitative Biology (QB)期刊是由清华大学、北京大学、高教出版社联合创办的全英文学术期刊。QB主要刊登生物信息学、计算生物学、系统生物学、理论生物学和合成生物学的最新研究成果和前沿进展,并为生命科学与计算机、数学、物理等交叉研究领域打造一个学术水平高、可读性强、具有全球影响力的交叉学科期刊品牌。

《前沿》系列英文学术期刊

由教育部主管、高等教育出版社主办的《前沿》(Frontiers)系列英文学术期刊,于2006年正式创刊,以网络版和印刷版向全球发行。系列期刊包括基础科学、生命科学、工程技术和人文社会科学四个主题,是我国覆盖学科最广泛的英文学术期刊群,其中12种被SCI收录,其他也被A&HCI、Ei、MEDLINE或相应学科国际权威检索系统收录,具有一定的国际学术影响力。系列期刊采用在线优先出版方式,保证文章以最快速度发表。

中国学术前沿期刊网

http://journal.hep.com.cn

特别声明:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。